Le nuove regole della ricerca AI (in breve)

-

Google fa le domande al posto tuo: In modalità AI, Google non lancia più una singola ricerca per la tua query, ma la scompone in tante sotto-ricerche parallele. Ogni domanda complessa viene suddivisa in micro-domande che l’AI esplora simultaneamente, coprendo diversi aspetti del tema.

-

Conta la rilevanza, non il ranking classico: La risposta che ottieni è una sintesi creata dall’AI che assembla informazioni da più fonti autorevoli. Non c’è più una lista di 10 link blu; l’AI restituisce un unico risultato ragionato con link di riferimento. Essere inclusi nel ventaglio (fan-out) di fonti conta più che essere primi in SERP.

-

Contenuti in “chunk” tematici: Google ora indicizza e seleziona frammenti di contenuto (chunk) rilevanti per sotto-temi, non solo pagine intere per parole chiave. Tematicità e struttura contano: pagine ben suddivise per argomento, con sezioni chiare e dati verificabili, hanno più chance di essere pescate dall’AI e citate nella risposta finale.

-

L’utente chiede meno, ottiene di più: L’esperienza di ricerca diventa conversazionale e integrata. L’utente formula una domanda complessa e l’AI gli consegna un report completo su misura, integrando anche dati aggiornati (es. grafici prezzi, info prodotti, mappe). Meno click e più risposte immediate significano meno traffico diretto ai siti, quindi la SEO tradizionale va ripensata.

-

Prepararsi all’era zero-click: Chi crea contenuti deve puntare a farsi scegliere dall’AI. Serve autorevolezza, struttura semantica e contenuti unici (esempi originali, dati proprietari, FAQ ben fatte). In un mondo in cui la risposta avviene nella pagina di ricerca stessa, la visibilità diretta va guadagnata dentro le risposte AI e non solo nei risultati organici classici.

Dalle query alle risposte: Google non è più solo un motore di ricerca

Fino a ieri il patto implicito con Google era lineare: digiti una query (“migliori friggitrici ad aria”), Google ti restituisce una SERP con una decina di link rilevanti, e sta a te cliccare, leggere e trovare la risposta. Oggi questo paradigma è stravolto. Con l’arrivo dell’AI Mode di Google, il motore di ricerca si trasforma in motore di risposta: non mostra più dieci risultati tra cui scegliere, ma elabora direttamente la risposta completa per te, spesso senza che tu debba lasciare Google.

Questo cambio di ruolo è alimentato dal sistema di Query Fan-Out, una delle innovazioni chiave introdotte da Google con l’AI generativa nella ricerca. Già il nome, letteralmente “ventaglio di query”, suggerisce cosa accade dietro le quinte: invece di una sola ricerca, Google ne fa molte contemporaneamente, aprendosi a ventaglio su varie direzioni del tuo argomento. Il risultato per l’utente è un’unica risposta sintetica e multidimensionale, come un super-riassunto fatto su misura.

Per capire la portata di questa rivoluzione, pensa che Google stesso definisce la sua Ricerca potenziata dall’AI come “il più grande prodotto AI al mondo”. Non è un mero vanto: è la constatazione che la Ricerca sta diventando conversazionale, contestuale e multimodale. Secondo i dati ufficiali, le esperienze di ricerca alimentate dall’AI (come l’AI Mode e le AI Overview) servono già 1,5 miliardi di utenti al mese. Un numero enorme, raggiunto in pochissimo tempo, a testimoniare che questa non è una beta per pochi eletti, ma la nuova normalità per le ricerche complesse.

Cos’è il Query Fan-Out e come funziona?

Immagina di porre una domanda complessa a un investigatore super intelligente anziché al classico motore di ricerca. Query Fan-Out è esattamente questo: il sistema prende la tua domanda iniziale e la “affida” a un’AI, la quale la spezza in tante piccole domande mirate, come farebbe un team di esperti che si divide i compiti. In pratica Google fa da solo le domande di approfondimento che un bravo ricercatore umano si porrebbe.

Poniamo che tu chieda: “Cosa fare a Nashville con un gruppo di amici?”. Tradizionalmente Google avrebbe cercato pagine con quelle parole chiave. Oggi, invece, l’AI interpreta il concetto e genera dietro le quinte una serie di ricerche correlate, ad esempio:

-

“Migliori ristoranti a Nashville per gruppi numerosi” – per la parte cibo.

-

“Locali con musica live a Nashville” – per il divertimento serale.

-

“Attività a Nashville adatte a bambini” – in caso il gruppo includa famiglie.

-

“Eventi in corso a Nashville questo weekend” – per attualizzare la risposta.

-

“Tour di gruppo a Nashville e dintorni” – per esperienze organizzate.

Ognuna di queste sotto-query viene lanciata quasi simultaneamente sui server di Google. È come se, invece di avere un solo “bibliotecario” che cerca un libro, Google inviasse dieci bibliotecari ognuno a cercare uno specifico capitolo in biblioteche diverse. Questa capacità di parallelizzare le ricerche è resa possibile da una combinazione di Large Language Model (Google utilizza una versione avanzata del modello Gemini) e dall’infrastruttura di ricerca collaudata.

Una volta raccolti i risultati da queste ricerche parallele, il sistema li mette insieme. Ma non semplicemente incollandoli: un motore di sintesi AI analizza tutti i pezzi, li valuta per qualità e pertinenza, e compone una risposta unitaria, coerente e strutturata. In questa risposta finale, l’AI spiega ciò che ha trovato: può elencarti diverse opzioni (ad esempio 2–3 attrazioni o ristoranti principali per ciascun aspetto richiesto), e soprattutto ti dice perché li consiglia, con un livello di dettaglio che ricorda un assistente umano. Il tutto corredato da link alle fonti originarie, in modo che l’utente possa approfondire cliccando (ma solo se lo desidera o ne ha bisogno).

Vediamo un altro esempio concreto, più tecnico, per chiarire il meccanismo. Immagina la query: “Migliori friggitrici ad aria nel 2025 per una famiglia”. Con il fan-out, l’AI di Google potrebbe generare al volo sottodomini della domanda come:

-

“Friggitrici ad aria facili da pulire” – (manutenzione e praticità d’uso)

-

“Meglio friggitrice ad aria doppio cestello o singolo?” – (tipologia e capacità)

-

“Recensioni utenti friggitrici ad aria X e Y” – (feedback reali su modelli popolari)

-

“Friggitrice ad aria vs forno ventilato” – (confronto con alternative)

-

“Funzione grill nella friggitrice ad aria: serve davvero?” – (valore aggiunto di feature particolari)

-

“Miglior rapporto qualità-prezzo friggitrice ad aria” – (aspetti economici)

Come vedi, alcune di queste ricerche contengono parole che non erano nella query originale, ma che un esperto di prodotto sicuramente esplorerebbe. L’AI ha capito che dietro “migliori friggitrici” c’è un intero universo di micro-domande: dalla facilità di pulizia, ai confronti tecnici, al budget. Non cerca più pagine che matchano letteralmente la frase “migliori friggitrici ad aria”, ma tanti pezzi di informazione specifici sparsi per il web.

Questi “pezzi” (i chunk di contenuto) possono trovarsi su forum specializzati, blog di cucina, siti di e-commerce con schede tecniche o testate tech con comparative. Google li pesca uno a uno: magari un paragrafo da un articolo di un blog, una tabella comparativa da un altro sito, una lista di pro e contro da un forum, e così via. Terminata la raccolta, assembla il puzzle: ti restituisce magari un paragrafetto introduttivo con le 3 friggitrici più consigliate, poi una sezione “Come scegliere: X vs Y” dove spiega il perché di doppio o singolo cestello, poi una sintesi di recensioni comuni (es. “tutti lodano la facilità di pulizia del modello X, ma segnalano tempi di cottura un po’ lunghi rispetto al modello Y”), e così via, fino a coprire tutti i sotto-temi chiave.

Il risultato finale per l’utente è straordinario: un’unica risposta articolata che copre ogni angolo della domanda originaria. In pratica Google usa sé stesso come strumento per trovare la risposta finale: l’AI sfrutta il motore di ricerca come backend, esegue più query “al posto tuo” e combina i risultati in un output unico.

Vale la pena notare che questa non è la stessa cosa del vecchio “People Also Ask”. Le caselle People Also Ask (PAA) che compaiono in SERP propongono domande correlate, ma funzionano in modo più limitato: espandono la ricerca in verticale, ovvero restano sullo stesso tema approfondendolo con FAQ simili. Il Query Fan-Out invece si espande in orizzontale, esplorando dimensioni diverse e più ampie del topic. È come passare da una ricerca monocorde a una ricerca polifonica: tante voci (sotto-query) che risuonano insieme per coprire l’intera melodia della risposta.

Dietro le quinte: dati in tempo reale e “ricerche profonde”

La potenza del fan-out non si esaurisce nel lanciare qualche query extra. Google ha integrato in questo meccanismo molte delle sue risorse real-time. Ad esempio, per rispondere a domande con componente shopping, l’AI attinge allo Shopping Graph (un enorme database di prodotti) aggiornato 2 miliardi di volte all’ora. Ciò significa che se chiedi “miglior smartphone sotto 500€”, mentre l’AI fa fan-out cercando recensioni, specifiche tecniche e confronti, in parallelo può interrogare il grafico prodotti per prezzi e disponibilità aggiornati al minuto. Similmente, per query finanziarie potrebbe consultare direttamente Google Finance per dati di borsa in real time, o per voli/viaggi attingere al database di Ricerca Voli o Google Travel.

Google chiama giustamente la sua Ricerca AI Mode “il più grande prodotto AI” perché combina LLM sofisticati (Gemini 2.5), indicizzazione web tradizionale e tool interni specializzati. Tutto orchestrato insieme per fornire risposte che uniscano conoscenza generale, freschezza dei dati e calcolo. Un esempio citato da Google è la funzione Deep Search: quando la domanda richiede davvero tanto ragionamento (immagina “sto scegliendo una cassaforte per la casa, quale mi consigliate?” che comporta valutare resistenza al fuoco, assicurazioni, meccanismi di chiusura, ecc.), il sistema può attivare una sorta di ricerca approfondita extra. Deep Search è come un fan-out potenziato: può lanciare decine o centinaia di sub-query e prendersi qualche minuto per completare la risposta, scavando in profondità su argomenti molto specifici prima di tornare con un report dettagliato. Chiaramente non avviene per ogni ricerca, sarebbe inefficiente, ma Google sta dicendo: se serve, l’AI non si ferma a 4-5 query parallele, può arrivare a farne quante ne occorrono per darti una risposta degna di un esperto umano.

La prova ufficiale: il brevetto “Thematic Search”

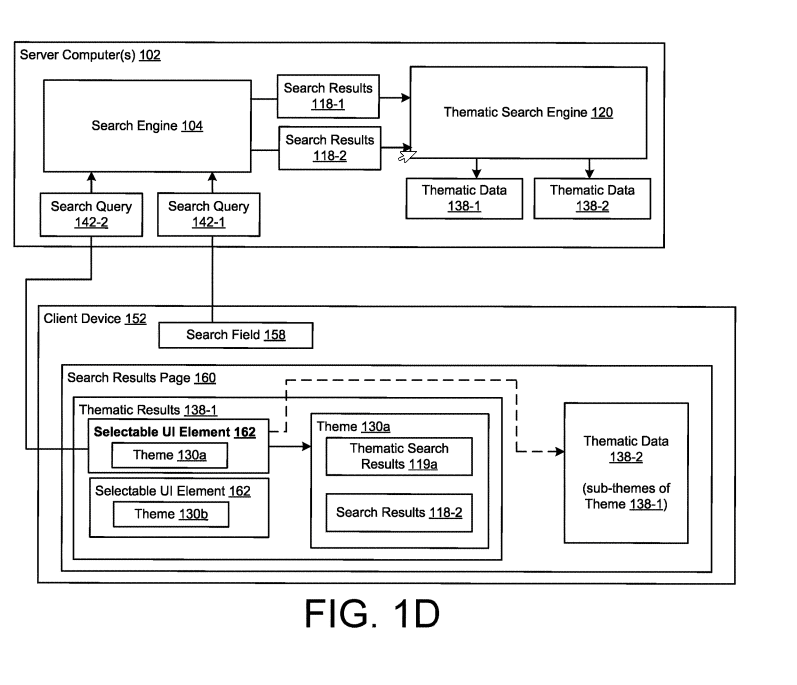

Se tutto questo ti sembra fantascienza o una teoria iper-tecnica, sappi che Google ha messo nero su bianco questi principi in un brevetto. A fine 2024 è stato depositato un brevetto chiamato “Thematic Search” che descrive proprio questo nuovo modo di organizzare la ricerca. È una lettura illuminante perché conferma che non si tratta di un semplice test, ma di una direzione strategica concreta per Google.

Cosa dice in sostanza Thematic Search? Che di fronte a una query ampia o complessa, il sistema anziché restituire la classica lista ordinata di link, identifica i temi principali nascosti nella query e raggruppa i risultati attorno a questi temi. Per ciascun gruppo tematico viene poi generata una sintesi con l’AI. L’utente si trova quindi davanti a blocchi di risposta per ogni sotto-argomento importante, invece del vecchio elenco di pagine.

Un esempio citato nel brevetto: query “trasferirsi a Denver”. Il sistema automaticamente potrebbe suddividere i risultati in temi come “quartieri migliori dove vivere”, “costo della vita”, “pro e contro del clima”, “opportunità di lavoro”, e per ognuno di essi creare un mini-articolo riassuntivo mescolando informazioni da più siti. In pratica al posto di dieci link blu avresti magari quattro riquadri tematici con titoletti tipo “Costo della vita a Denver”, “Lavoro e stipendi a Denver” ecc., ciascuno con un paragrafo riassuntivo generato dall’AI che condensa il meglio di vari articoli su quell’aspetto, e magari un pulsante “Approfondisci” se vuoi vedere più dettagli o altri link.

Fa quasi impressione leggere che “i contenuti di più siti vengono mescolati, riorganizzati e riscritti da un modello linguistico”. Google quindi ammette (in linguaggio da brevetto) che l’AI potrà prendere un paragrafo dal tuo sito, una frase da quello del tuo competitor, un dato da Wikipedia e cucirli insieme per rispondere all’utente senza che quest’ultimo visiti nessuno di questi siti direttamente. I brevetti spesso disegnano scenari possibili: qui descrivono esattamente ciò che stiamo già vedendo nei box generativi di SGE/AI Mode.

Un altro dettaglio interessante del brevetto: il modo in cui le interazioni dell’utente con queste risposte tematiche influenzeranno la visibilità futura dei siti. Ad esempio, se l’utente espande il tema “quartieri” e clicca su un link interno, il sistema impara che quel tema (e quei siti citati) sono stati utili, e questo potrebbe aumentare la probabilità che simili fonti siano incluse in risposte analoghe. Al contrario, se una certa fonte viene ignorata costantemente, forse l’AI la sceglierà meno spesso nel fan-out successivo. È un nuovo tipo di segnale di feedback che si aggiunge al nostro già complicato mondo SEO.

In sintesi, il brevetto Thematic Search è la pistola fumante: conferma che il Query Fan-Out non è una trovata temporanea, ma l’inizio di un nuovo capitolo della ricerca. Google punta su risposte tematiche, sintetizzate e zero-click, e sta brevettando le tecnologie per farlo in modo sistematico. Per chi fa SEO, questo vuol dire che le vecchie certezze (ottimizza la pagina per X keyword e rankerai) vacillano. Bisogna progettare i contenuti per far sì che entrino a far parte di questi temi e di queste sintesi, altrimenti il rischio è di diventare invisibili pur avendo magari un buon ranking tradizionale.

SEO: come restare visibili nell’era del Fan-Out

La domanda cruciale ora è: che ne sarà del mio sito web e del mio traffico in questo scenario? Perché, diciamolo chiaramente, se l’utente ottiene tutto ciò che gli serve direttamente su Google, quanti vorranno ancora cliccare il nostro bel risultato organico? Siamo di fronte al famigerato zero-click elevato all’ennesima potenza. Già in passato snippet, knowledge graph e risultati locali rubavano click; ora abbiamo risposte AI esaustive che rischiano di svuotare di traffico intere categorie di query.

Questo non significa però che fare SEO diventi inutile, ma sicuramente cambia gli obiettivi e i metodi. Prima ottimizzavamo per farci trovare e ottenere un click; ora dobbiamo ottimizzare per farci usare dall’AI. In altre parole, il nostro contenuto deve essere talmente pertinente, completo e autorevole che Google lo voglia includere nelle sue risposte. Dobbiamo diventare fonte primaria per l’AI, anche se l’utente finale magari non ci vede direttamente. È un cambio di mentalità non da poco.

Ecco alcune strategie e concetti chiave per adattarsi:

-

Pensa in termini di entità e temi, non solo keyword: Il fan-out e il clustering per temi significa che Google cerca di coprire un argomento a 360°. Bisogna coprire anche noi l’argomento in modo ampio e strutturato. Non basta un articolo “migliori friggitrici ad aria” con 10 prodotti in lista; serve contesto intorno: come si puliscono, differenze con altri strumenti, pro/contro di funzioni, ecc. Magari non tutto in una pagina, ma con una solida architettura di contenuti collegati. Bisogna creare hub tematici in cui ogni sotto-argomento ha la sua pagina ben ottimizzata e approfondita (che diventa il chunk perfetto da citare), e tutte legate semanticamente. In pratica, chi copre meglio i subtopic ha più chance di essere incluso nel ventaglio AI.

-

Chunk e passaggi estrapolabili: La generativa preferisce contenuti che può facilmente “spezzettare” in modo sensato. Paragrafi brevi e focalizzati, liste puntate, tabelle riassuntive, FAQ in pagina… Sono tutti formati che un’AI adora perché può estrarne esattamente la frase o il dato che serve, senza dover leggere romanzi. Un muro di testo prolisso e non segmentato invece rischia di essere ignorato: l’AI potrebbe non trovare un punto preciso da estrarre e andrà da chi glielo offre su un piatto d’argento. Struttura i tuoi contenuti pensando alla cavabilità: ogni paragrafo dovrebbe avere quasi il suo mini-topic e poter essere compreso a sé.

-

E-A-T ai massimi livelli: L’AI Mode cita le fonti più autorevoli e affidabili. Quindi sì, ancora una volta tornano in scena Experience, Expertise, Authoritativeness, Trustworthiness. Se due siti dicono la stessa cosa, l’AI con ogni probabilità citerà quello con maggiore reputazione (agli occhi di Google). Questo significa: cura l’author profile, evidenzia credenziali, linka a fonti di qualità, ottieni menzioni e backlink autorevoli nel tuo settore, aggiorna i contenuti di frequente. Tutto ciò alimenta quei segnali qualitativi indiretti che fanno percepire il tuo sito come risorsa affidabile da includere.

-

Dati strutturati e markup: Se il futuro è un mondo di risposte aggregate, fornire metadati chiari ai motori è ancora più importante. Markup schema per definire recensioni, prezzi, domande FAQ, definizioni, ecc. Potrebbe aiutare l’AI a capire meglio e più rapidamente cosa tratta il tuo contenuto. Non dico che basti a farti scegliere, ma se già Google analizza titoli e struttura HTML per costruire i suoi riassunti (come accennato dal brevetto), tu assicurati che siano puliti, gerarchici e ricchi di segnali semantici. Una buona architettura informativa può fare la differenza su quali pezzi del tuo sito saranno estratti e riassunti.

-

Monitorare e adattarsi: Siamo in territorio nuovo. Conviene fare test periodici: cerca le query chiave del tuo settore in modalità AI (dove disponibile) e guarda chi viene citato e per cosa. Potresti scoprire che magari la tua pagina, pur ben posizionata in SERP classica, non viene mai inclusa nei snapshot AI. Chiediti perché: manca qualche pezzo? Il competitor citato offre un esempio pratico o un grafico che tu non hai? O magari il tuo contenuto è OK ma Google non lo vede (problemi di crawling, oppure sei penalizzato in qualche modo qualitativo). Inizia a pensare in termini di Answer Presence: la tua presenza nelle risposte AI, non solo nelle SERP.

Insomma, la visibilità SEO si sta trasformando. Non è più soltanto questione di salire in classifica nei risultati tradizionali, ma di entrare nel ventaglio di fonti che alimentano le risposte AI. In gergo si inizia a parlare di GEO – Generative Engine Optimization: l’ottimizzazione per i motori generativi. Il concetto è: se non sei nei chunk, non esisti.

Chi saprà adattarsi ora guadagnerà un vantaggio competitivo enorme, perché potrà riemergere in questo nuovo panorama dove molti competitor magari brancoleranno al buio chiedendosi perché le visite organiche calano. È un momento di cambiamento epocale: come ogni rivoluzione tecnologica, porta incognite ma anche opportunità per chi la comprende a fondo.

Bing e gli altri: il fan-out esiste anche altrove?

Google non è l’unico a integrare l’AI nella ricerca, e viene spontaneo chiedersi se anche altri motori o sistemi LLM stiano adottando strategie simili al Query Fan-Out. La risposta è sì, in parte – ma con differenze interessanti.

Bing, ad esempio, ha evoluto la sua ricerca con l’AI (Bing Chat, spesso chiamato anche CoPilot in contesti Microsoft). Bing adotta un approccio leggermente diverso: quando interpreti una domanda complessa, tende a svolgere più attività in parallelo ma sulla singola query. In pratica Bing crea diverse rappresentazioni della query (una più testuale per il motore classico, una vettoriale per la ricerca semantica, identifica entità note) e poi fa una ricerca ibrida combinando risultati per coprire i possibili intenti. È come se Bing dicesse: “prendo questa domanda e la guardo da più angolazioni in parallelo, ma non esplodo in tante domande diverse come Google”. Questo riflette una filosofia leggermente più conservativa: Bing si affida molto al suo motore di ranking collaudato per trovare le risposte rilevanti, anziché generare attivamente numerose sub-query.

Ciò non significa che Bing non faccia ricerche aggiuntive: nelle conversazioni multi-turno, Bing Chat spesso esegue ricerche ulteriori quando servono dettagli specifici (lo puoi notare quando appare la scritta “Cercando per [parola chiave]…” durante una chat). Ma tipicamente, Bing cerca di coprire vari intenti possibili con la query iniziale. Ad esempio, se chiedi a Bing Chat “consigliami un itinerario di 3 giorni a Tokyo”, molto probabilmente farà una singola ricerca, ma quella ricerca restituirà sia siti di itinerari generici, sia il meteo, sia magari suggerimenti di eventi – e l’AI di Bing li sintetizzerà. Google invece, col fan-out, avrebbe potuto fare distinte query tipo “itinerario 3 giorni Tokyo blog”, “Eventi a Tokyo questo mese”, “Meteo Tokyo primavera”, ecc., prima di darti la risposta.

In poche parole, Google “esplode” la query, Bing tende più a raffinarla internamente. È una differenza di architettura: Google privilegia la massima copertura tematica generando domande aggiuntive, Bing privilegia la precisione dell’algoritmo di ranking e delle sue diverse pipeline (testuale, semantica, locale, ecc.) per servire l’AI. Dal punto di vista SEO, questo implica che su Bing restano cruciali i fattori classici (buona indicizzazione, contenuti di qualità, backlink) per apparire nei risultati che poi l’AI sintetizzerà. Su Google, oltre a quelli, conta di più pensare se e come il tuo contenuto risponde a micro-domande che l’AI potrebbe generare.

E gli altri LLM e motori AI indipendenti? Molti stanno sperimentando approcci simili al fan-out, anche se magari non lo chiamano così. Ad esempio, motori come Perplexity.ai o il defunto NeevaAI seguono l’idea della Retrieval-Augmented Generation (RAG): l’LLM prende la query, fa più ricerche sul web (spesso su Bing API) e poi genera la risposta con citazioni. Di fatto è un fan-out rudimentale: genera vari termini correlati e lancia più query per essere sicuro di pescare abbastanza informazioni. Quindi sì, il concetto di base – “un’AI che lancia sottoric rche multiple e poi sintetizza” sta diventando comune in vari sistemi.

Persino ChatGPT con i plugin o con la funzione di navigazione web esegue una forma di fan-out, sebbene manuale: quando gli fai una domanda complessa e ha accesso a internet, può iterare cercando prima una cosa, poi un’altra, seguire link, ecc. La differenza è che ChatGPT in versione generica non ha una procedura automatizzata come Google AI Mode, ma con i giusti prompt può simulare il processo (“ora cerco X… ora cerco Y…”). Alcune ricerche accademiche parlano di far cooperare più agenti AI in parallelo (multi-agent systems) per risolvere compiti complessi: il query fan-out di Google in fondo è una versione “domata” di un sistema multi-agente, dove le sub-query sono agenti semplicissimi e coordinati centralmente (non chiacchierano tra loro, non vanno fuori script, fanno solo il loro pezzettino). È un approccio più facile da controllare e scalare per un prodotto come la ricerca web.

In definitiva, Google oggi è all’avanguardia di questo paradigma fan-out applicato su vasta scala, ma tutto il settore si muove verso l’integrazione di LLM e ricerche multiple. Non a caso Microsoft, OpenAI, Meta e altri parlano sempre più di “ragionamento multistep” e tool use per i loro modelli. Presto, fare una domanda a un motore AI significherà ovunque attivare non una risposta singola ma un processo di ricerca e sintesi.

Cambiamento di rotta: da SEO a GEO (Generative Engine Optimization)

Siamo di fronte a un cambiamento di rotta storico. Chi lavora sul web marketing e sulla SEO dovrà ripensare le proprie strategie. Non si tratta solo di aggiungere qualche parola chiave in più o ottimizzare i tag come facevamo da anni. Qui parliamo di progettare ecosistemi di contenuti che sappiano dialogare con intelligenze artificiali.

Mi piace chiamarla GEO Generative Engine Optimization, parafrasando la SEO. Il principio rimane lo stesso di sempre: comprendere il bisogno dell’utente e creare la miglior risorsa per soddisfarlo. Solo che ora la risorsa deve essere fruibile e preferita da un AI, oltre che dall’utente umano.

Significa che la qualità conta più che mai, ma va unita a una struttura adatta. Significa che dobbiamo eccellere nei contenuti e allo stesso tempo “pensare come l’AI” per capire come verranno usati quei contenuti. È un nuovo gioco e le regole iniziano ora a delinearsi: chi inizia subito a giocare e a sperimentare avrà un vantaggio enorme quando questa diventerà la norma.

La visibilità online non sparisce, ma si sposta di luogo: sempre meno sui nostri siti, sempre più dentro le risposte. Il nostro compito come professionisti digital non è più solo farsi trovare, ma farsi scegliere dalle AI come portatori di valore. Chi riuscirà in questo potrà ancora ottenere traffico (perché comunque l’AI fornisce link alle fonti e molti utenti cliccano per approfondire) e soprattutto mantenere rilevanza del brand in un contesto in cui il brand rischia di non apparire affatto.

Nessuno ha la sfera di cristallo su dove esattamente andremo a finire, ma una cosa è certa: il Query Fan-Out è qui per restare, e sta ridefinendo l’ecosistema della ricerca. Da ingegnere e consulente SEO che ha visto evolvere Google per anni, trovo che questa sia una delle sfide più affascinanti (e complesse) di sempre. Dovremo unire tecnica, creatività e una nuova dose di strategia per continuare a portare visibilità ai progetti sul web. La buona notizia è che chi innova e sperimenta ora può davvero fare la differenza. La cattiva, per chi sperava in una soluzione semplice, è che non esistono trucchi o scorciatoie: serviranno contenuti impeccabili, dati ben organizzati, e test continui per allinearsi a questi nuovi motori di risposta.

Niente panico, dunque, ma nemmeno inerzia: la SEO si evolve in GEO e l’era del fan-out premia chi è pronto ad adattarsi. Il bello (o il brutto) del digitale è che non ci si annoia mai e questa rivoluzione ne è la prova. Il ventaglio è aperto: facciamo in modo di esserci dentro. 🙂

Brevetti correlati:

-

US12158907B1 – “Thematic Search” (Google, depositato Dicembre 2024)